Nvidia的新一代Blackwell平台将于2025年初登陆Google Cloud

本周在拉斯维加斯举行的Google Cloud Next活动中,意味着一系列新的实例类型和加速器将面向Google Cloud平台。除了新的定制Arm架构的Axion芯片外,今年大部分的新闻都与AI加速器有关,无论是由Google开发还是来自Nvidia。

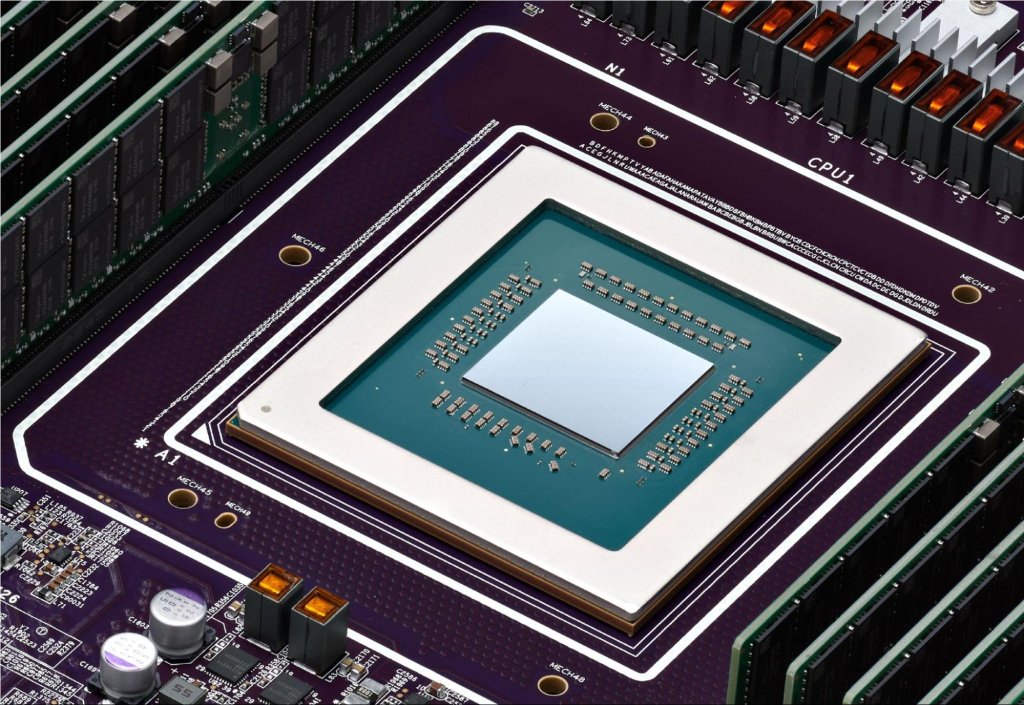

仅仅几周前,Nvidia宣布了其Blackwell平台。但不要指望谷歌会很快提供这些机器。支持高性能的Nvidia HGX B200用于AI和HPC工作负载以及GB200 NBL72用于大型语言模型(LLM)训练将于2025年初推出。谷歌发布公告中的一个有趣细节是:GB200服务器将采用液冷技术。

这可能听起来有点过早的公告,但Nvidia表示其Blackwell芯片直到今年年底才会公开发布。

Blackwell之前

对于今天需要更强大计算能力来训练LLMs的开发者,谷歌还宣布了A3 Mega实例。这个实例由谷歌与Nvidia共同开发,采用了业界标准的H100 GPU,同时结合了一个新的网络系统,每GPU的带宽可提供高达两倍。

另一个新的A3实例是A3 confidential,谷歌表示可以帮助客户“在训练和推理期间更好地保护敏感数据和AI工作负载的机密性和完整性。”该公司长期以来提供加密数据使用的机密计算服务,启用后,机密计算将通过受保护的PCIe对数据传输进行加密,无需进行任何代码更改,谷歌表示。

至于谷歌自己的芯片,该公司于周二推出了其Cloud TPU v5p处理器——这是迄今为止最强大的自家AI加速器,已正式推出。这些芯片的浮点运算每秒性能提高2倍,内存带宽速度提高3倍。

所有这些快速芯片都需要一个能跟得上它们的底层架构。因此,除了新芯片外,谷歌还于周二宣布了新的AI优化存储选项。Hyperdisk ML是公司的下一代块存储服务,现在处于预览阶段,根据谷歌的说法,可以将模型加载时间提高高达3.7倍。

Google Cloud还推出了一系列更传统的实例,由英特尔第四和第五代至强处理器提供动力支持。例如,新的综合用途C4和N4实例将采用第五代Emerald Rapids至强芯片,其中C4侧重于性能,而N4则侧重价格。新的C4实例目前处于私密预览阶段,而N4实例则已正式推出。

此外,还有处于预览阶段的新C3裸金属机器,采用较老的第四代英特尔至强处理器,以及处于预览阶段的X4内存优化裸金属实例和Z3,谷歌云的第一个面向存储优化虚拟机,承诺“在顶尖云平台中提供存储优化实例的最高IOPS。”

Nvidia在GTC举办的主题演讲上有一些惊喜